Découvrez comment Docker révolutionne le monde du DevOps en simplifiant le déploiement des applications grâce à la conteneurisation

Dans le monde du développement logiciel moderne et du DevOps, Docker est devenu le standard de référence pour les développeurs. Il a révolutionné la manière dont les application sont créées, testées et déployées en démocratisant les conteneurs. Les conteneurs et Docker permettent aux développeurs de créer des environnements de développement identiques à ceux de production.

Cet article vise à démystifier Docker et la conteneurisation en expliquant les concepts fondamentaux, leur fonctionnement, et leur importance cruciale dans l'écosystème technologique actuel. Vous y trouverez une explication détaillée des principes de Docker et de ses avantages pratiques, vous permettant de comprendre pleinement son impact.

En lisant cet article jusqu'au bout, vous acquerrez une nouvelle perspective sur Docker et serez capable de déterminer quand et comment l'utiliser efficacement dans vos projets.

Comprendre les Conteneurs

Un conteneur est une unité logicielle standard qui regroupe le code source et toutes ses dépendances, telles que les bibliothèques et les fichiers de configuration. Il permet une exécution fiable d'un environnement à un autre. Contrairement à la virtualisation traditionnelle des serveurs ou des machines, les conteneurs ne contiennent pas d'image de système d'exploitation, ce qui les rend plus légers et portables.

Cette légèreté permet aux conteneurs de démarrer très rapidement, surtout si l'architecture logicielle est bien respectée. En termes simples, un conteneur peut être vu comme une instance d'une application microservice. Pour les déploiements d'applications plus importants, plusieurs conteneurs peuvent être déployés pour supporter la charge, et ceux-ci peuvent être gérés par un orchestrateur de conteneurs tel que Kubernetes.

Principes des conteneurs

- Isolation : les conteneurs isolent les application du reste du système. Chaque conteneur a ses propres ressources dédiées comme le CPU, la mémoire et le stockage. Cette isolation permet à plusieurs conteneurs de s'éxecuter sur la même machine sans interférence. L'isolation logique est possible grâce aux mécanismes de cgroups et namespaces fournis par le noyau Linux.

- Portabilité : un conteneur empaquete tout ce que dont une application a besoin pour fonctionner : code source, librairies, variables d'environnement, configuration. Les applications conteneurisées sont portables et reproductibles. Ceci est particulièrement utile pour garantir le même fonctionnement du livrable de développement vers la production.

- Léger et efficace : contrairement aux machines virtuelles (VMs), les conteneurs ne nécessitent pas un système d'exploitation complet. Les conteneurs partagent noyau du système d'exploitation de l'hôte. Cela les rend beaucoup plus léger et rapides à démarrer qu'un serveur.

Isolation et Gestion des Ressources

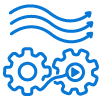

Pour comprendre comment Docker parvient à isoler les applications et à gérer efficacement les ressources, il est essentiel de se pencher sur deux concepts clés du noyau Linux : les cgroups (Control Groups) et les namespaces. Ces technologies sont à la base de la conteneurisation et permettent d'assurer que chaque conteneur fonctionne de manière isolée et optimisée.

- cgroups (Control Groups) : Les cgroups permettent de limiter, de prioriser et d'isoler l'utilisation des ressources (CPU, mémoire, disque, réseau) par un groupe de processus. Ils assurent que chaque conteneur utilise uniquement les ressources qui lui sont allouées, évitant ainsi que les conteneurs interfèrent les uns avec les autres.

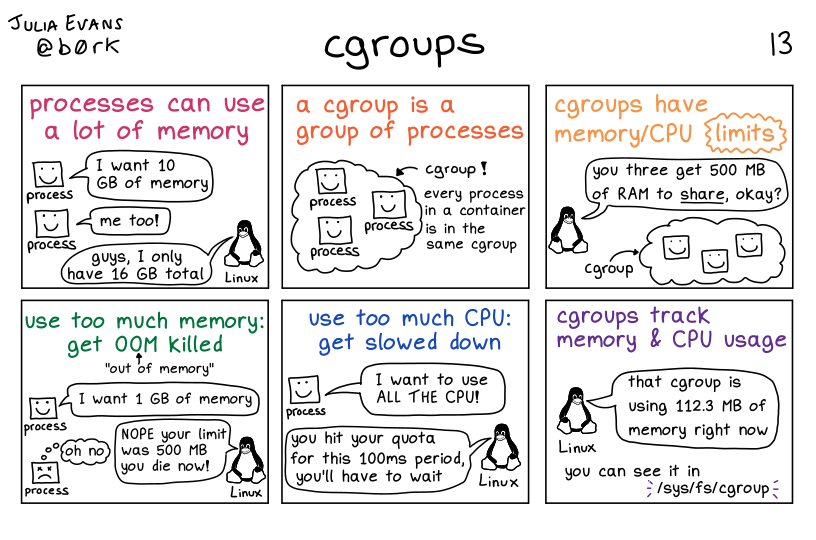

- namespaces : Les namespaces isolent les ressources système, telles que les PID (Process IDs), les réseaux, les utilisateurs et les systèmes de fichiers, entre les conteneurs. Cette isolation permet aux conteneurs de croire qu'ils exécutent leurs propres instances indépendantes de ces ressources.

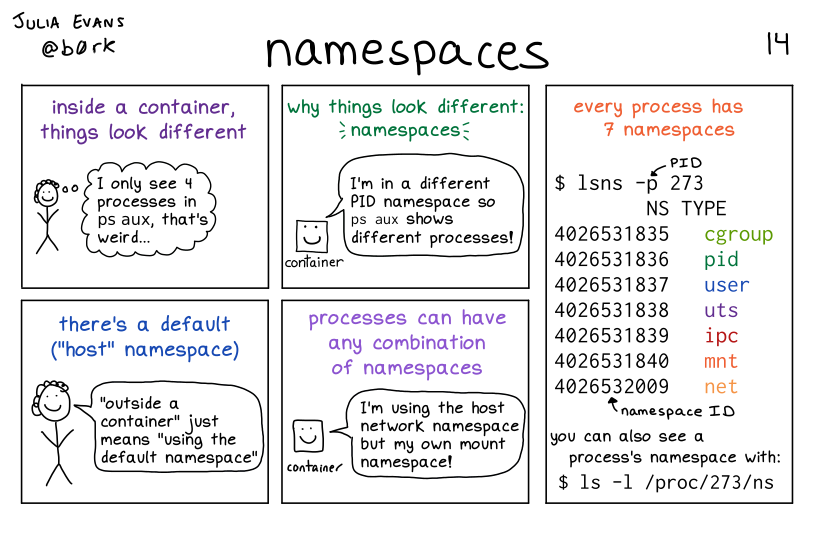

Différences entre conteneurisation et virtualisation

La conteneurisation et la virtualisation sont deux technologies essentielles pour optimiser l'utilisation des ressources informatiques et simplifier le déploiement des applications. Bien qu'elles poursuivent des objectifs similaires, leurs approches et fonctionnements diffèrent :

- La virtualisation consiste à créer plusieurs machines virtuelles (VMs) sur une seule machine physique. Chaque VM fonctionne comme un ordinateur indépendant avec son propre système d'exploitation, ses applications et ses ressources.

- La conteneurisation permet de créer des environnements isolés appelés conteneurs sur un seul système d'exploitation. Chaque conteneur partage le noyau de l'OS hôte mais fonctionne comme une instance indépendante avec ses propres bibliothèques, dépendances et fichiers système.

Avantages des conteneurs

- Moins de Surcharge : Les conteneurs nécessitent moins de ressources système que les environnements de machines virtuelles classiques ou matérielles, car ils n'incluent pas les images complètes des systèmes d'exploitation. Cela réduit la consommation de ressources et améliore les performances globales.

- Amélioration de la Portabilité : Les applications exécutées dans des conteneurs peuvent être facilement déployées sur divers systèmes d'exploitation et plateformes matérielles sans modifications. Cette portabilité garantit que les applications fonctionnent de manière cohérente dans différents environnements.

- Meilleure Cohérence des Opérations : Les équipes DevOps peuvent être assurées que les applications conteneurisées s'exécuteront de la même manière, quel que soit l'environnement de déploiement. Cette cohérence réduit les erreurs liées aux différences d'environnement et simplifie le processus de déploiement.

- Efficacité Accrue : Les conteneurs permettent de déployer, de corriger et de faire évoluer les applications plus rapidement. La capacité à isoler les applications et leurs dépendances dans des conteneurs distincts facilite la gestion et le déploiement continu.

- Optimisation du Développement d'Applications : Les conteneurs accélèrent les cycles de développement, de test et de production grâce à l'utilisation de méthodologies agiles et DevOps. Cela permet aux équipes de développement de livrer des mises à jour et des nouvelles fonctionnalités plus rapidement, tout en maintenant une qualité élevée.

Qu'est-ce que Docker ?

Docker est un outil open-source qui permet aux développeurs de créer, déployer et gérer des applications dans des conteneurs. Docker facilite la conteneurisation des applications.

Historique de Docker

L'origine de Docker remonte à des technologies plus anciennes comme LXC (Linux Containers). LXC permettaient déjà d'exécuter plusieurs systèmes Linux sur un même noyau. Bien que LXC offrait un environnement de conteneurisation, sa complexité et son manque d'outils de gestion conviviaux limitaient son adoption.

Docker a été créé par Solomon Hykes dans le cadre de dotCloud, une plateforme de PaaS. L'idée était de permettre un développement et un déploiement plus rapides d'applications en facilitant la gestion des dépendances et des environnements.

La première version stable de Docker a été lancée en mars 2013 et a rapidement suscité un engouement majeur, en répondant aux défis d’intégration et de déploiement rencontrés dans des environnements complexes.

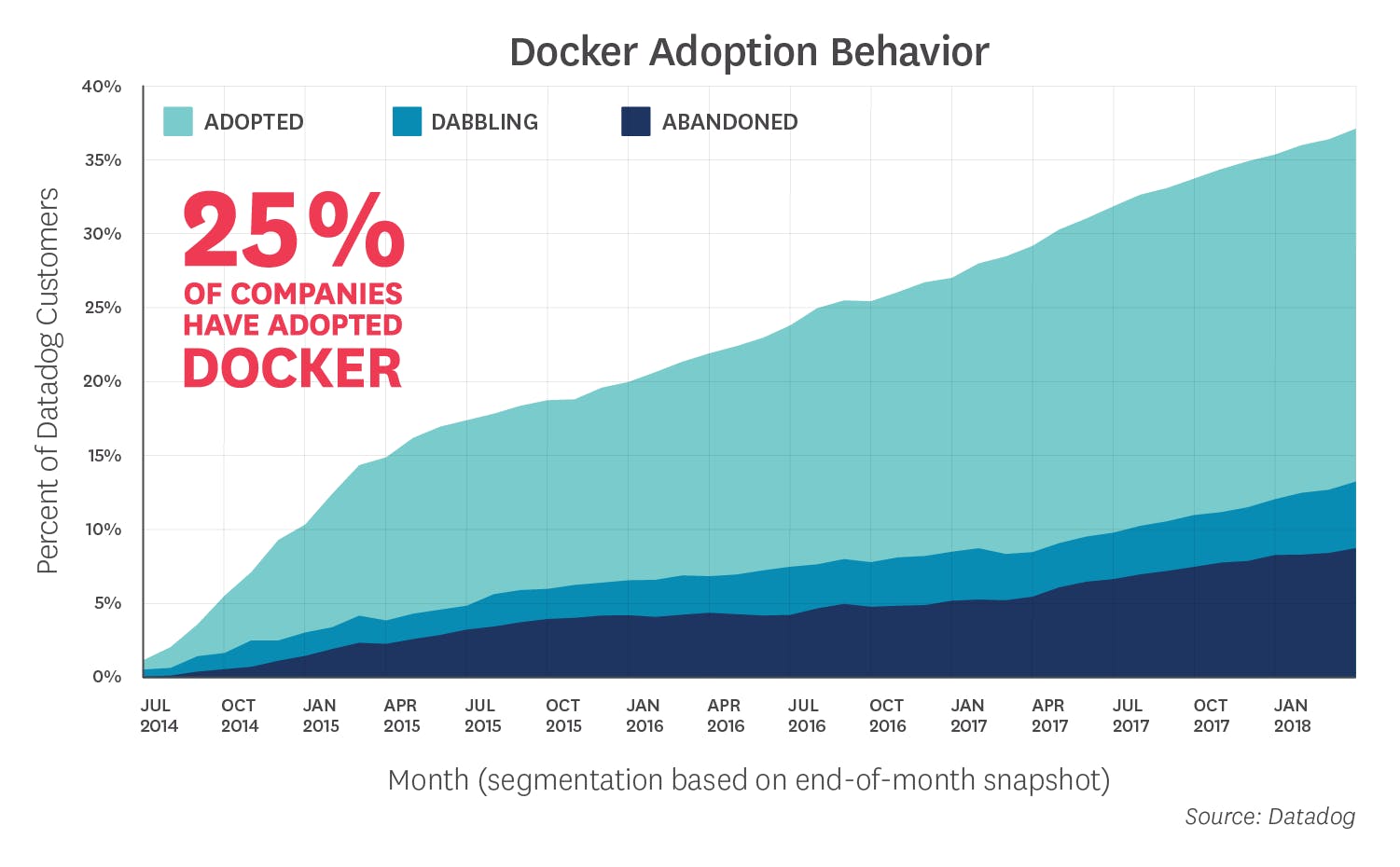

Adoption de Docker

L’adoption de Docker a été fulgurante, tant dans les startups que dans les grandes entreprises. Sa popularité repose sur plusieurs facteurs clés :

- Simplicité d’utilisation : Docker permet aux développeurs de créer, déployer et exécuter des applications facilement, grâce à des commandes simples et des fichiers de configuration lisibles, comme les Dockerfiles.

- Portabilité : Les applications contenues dans Docker peuvent fonctionner de manière identique sur n’importe quel environnement, qu'il s'agisse d'une machine locale, d'un serveur cloud ou d'un data center. Cela réduit considérablement les problèmes de compatibilité.

- Écosystème riche : Docker a engendré un vaste écosystème d’outils et de services, tels que Docker Hub pour le partage d’images, et Docker Compose pour gérer des applications multi-conteneurs. Ces outils permettent aux équipes de collaborer efficacement et de déployer des applications complexes rapidement.

- Communauté : Docker bénéficie d'une communauté active qui contribue à son amélioration continue. De nombreux tutoriels, plugins et ressources sont disponibles pour aider les utilisateurs à tirer le meilleur parti de la technologie.

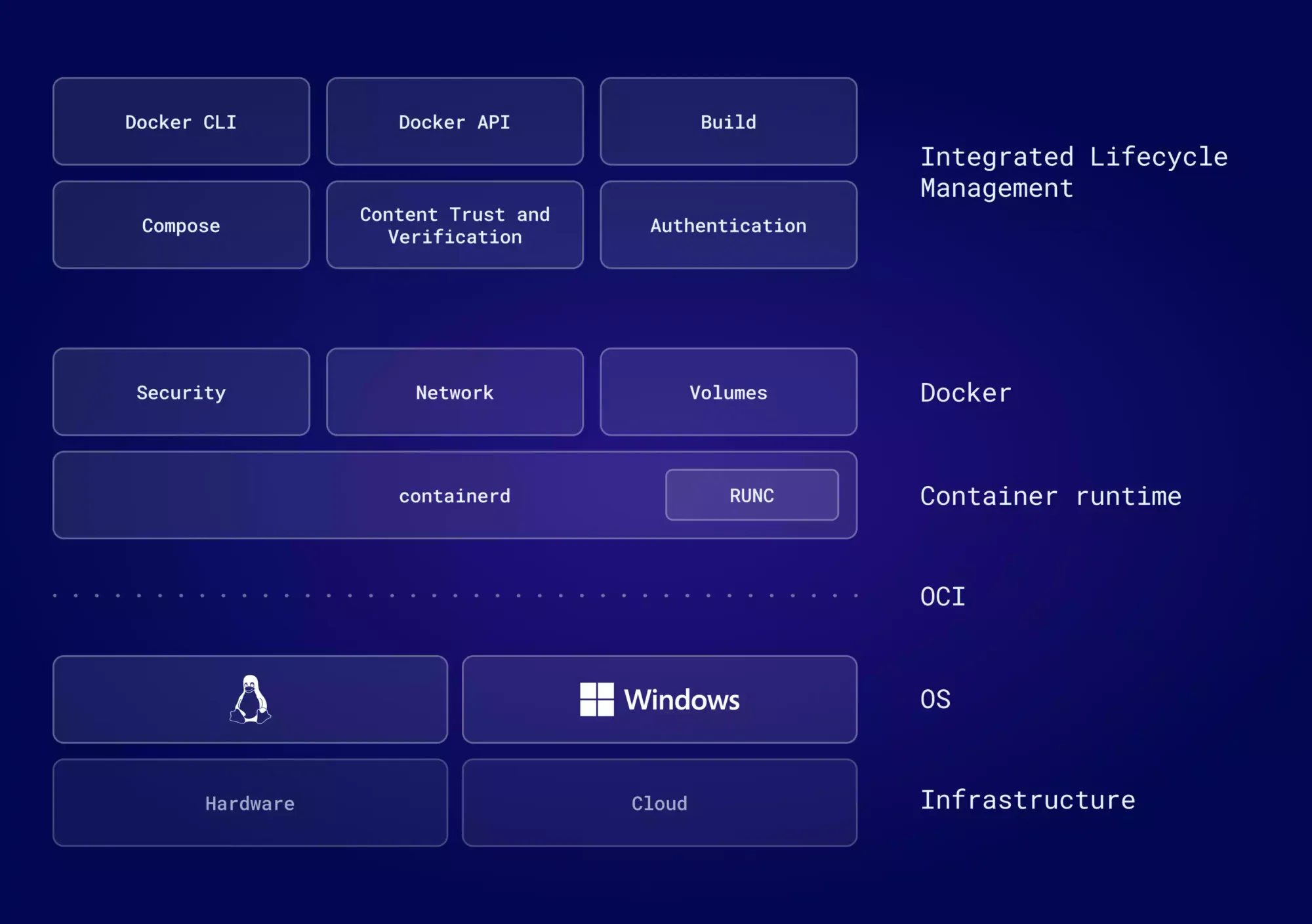

Architecture de Docker

L'architecture de Docker a évolué à plusieurs reprises depuis sa création. Docker à ses début était construit sur LXC et sur une architecture monolithique. Cette architecture était constituée en trois composants distincts :

- docker-engine (dockerd)

- docker-containerd (containerd)

- docker-runc (runc)

Docker et d'autres grandes organisations ont contribué à établir un standard pour l'exécution des conteneurs et de ses couches. Ce standard industriel ouvert s'appelle l'OCI (Open Container Initiative) pour l'exécution des conteneurs et les spécifications associées.

Voici quelques changements architecturaux notables au sein de Docker :

- En 2024, Docker est passé de LXC à libcontainer (faisant maintenant parti de runc)

- runc : un outil en ligne de commande permettant de démarrer des conteneurs conformes à toutes les spécifications de l'OCI.

- En 2016, Docker a séparé son composant de gestion de conteneurs de son monolithe, créant ainsi containerd.

- containerd et runc font maintenant partie de la CNCF (Cloud Native Foundation), avec des contributions de nombreuses organisations

Le diagramme ci-dessous présente l'architecture actuelle de Docker (2024) :

On remarque que le runtime de conteneurs et que Docker sont séparés. Nous allons voir quel est le rôle de chacun de ces composants dans l'architecture de Docker.

Docker Engine

Le Docker Engine est une plateforme permettant de construire et de conteneuriser les applications. Il agit comme une application client-serveur avec les composants suivants :

- Un serveur avec un process daemon : dockerd. Il crée et gère les objets Docker, tels que les images, les conteneurs, les réseaux et volumes.

- Des APIs qui spécifient les interfaces que les programmes peuvent utiliser pour communiquer avec le daemon Docker et lui donner des instructions.

- Une interface de ligne de commande (CLI) : docker-cli. La CLI utilise les API Docker pour contrôle ou interagir avec le daemon Docker par le biais de scripts ou de commandes directes

Runc

Runc (containerd) est responsable de la création et de l'exécution des conteneurs en se basant sur les spécifications OCI :

- Gestion des conteneurs : Runc initialise les conteneurs et le démarrage des processus à l'intérieur de ceux-ci.

- Gestion des namespaces : Runc crée et configure les namespaces Linux pour isoler les conteneurs les uns des autres et du système hôte. Les namespaces comprennent les espaces de noms de processus (PID), de réseau, de montage et plus encore.

- Gestion des cgroups : Runc configure les groupes de contrôle pour gérer les ressources allouées aux conteneurs comme la mémoire et le CPU. Il assure ainsi une gestion efficaces des ressources physiques.

- Configuration des conteneurs : Runc utilise des fichiers de configuration conformes aux spécifications OCI pour déterminer les paramètres du conteneurs. Il s'agit des volumes montés, des variables d'environnements et des commandes à exécuter.

Containerd

containerd est un runtime de conteneur léger qui gère le cycle de vie des conteneurs sur un système. Il est souvent utilisé comme composant de base pour des plateformes de gestion de conteneurs comme Docker et Kubernetes.

Voici une vue d'ensemble de ses fonctionnalités principales :

- Gestion des Images : Téléchargement, stockage, et gestion des images de conteneurs. containerd prend en charge plusieurs formats d'images, y compris le format OCI.

- Gestion des Conteneurs : Création, exécution, et gestion des conteneurs. Il gère les tâches liées aux conteneurs comme la configuration des namespaces, la gestion des cgroups, et le montage des volumes.

- Gestion des Snapshots : Création et gestion des snapshots de systèmes de fichiers, ce qui permet de créer des images des états de conteneurs à des moments donnés.

- API : Fournit une API (gRPC) que les clients peuvent utiliser pour interagir avec le runtime des conteneurs. Cette API permet de gérer les conteneurs et les images de manière programmatique.

- Support de Plugins : Permet l'utilisation de plugins pour étendre ses fonctionnalités. Par exemple, des plugins pour le réseau, le stockage, ou le contrôle d'accès peuvent être ajoutés.

- Interopérabilité : containerd respecte les spécifications de l'OCI pour garantir la compatibilité et l'interopérabilité entre différents outils et plateformes.

Docker utilise containerd pour gérer les conteneurs sous-jacents à son API plus haute niveau. Docker fournit des fonctionnalités additionnelles comme l'orchestration et l'interface utilisateur, tandis que containerd gère le runtime des conteneurs.

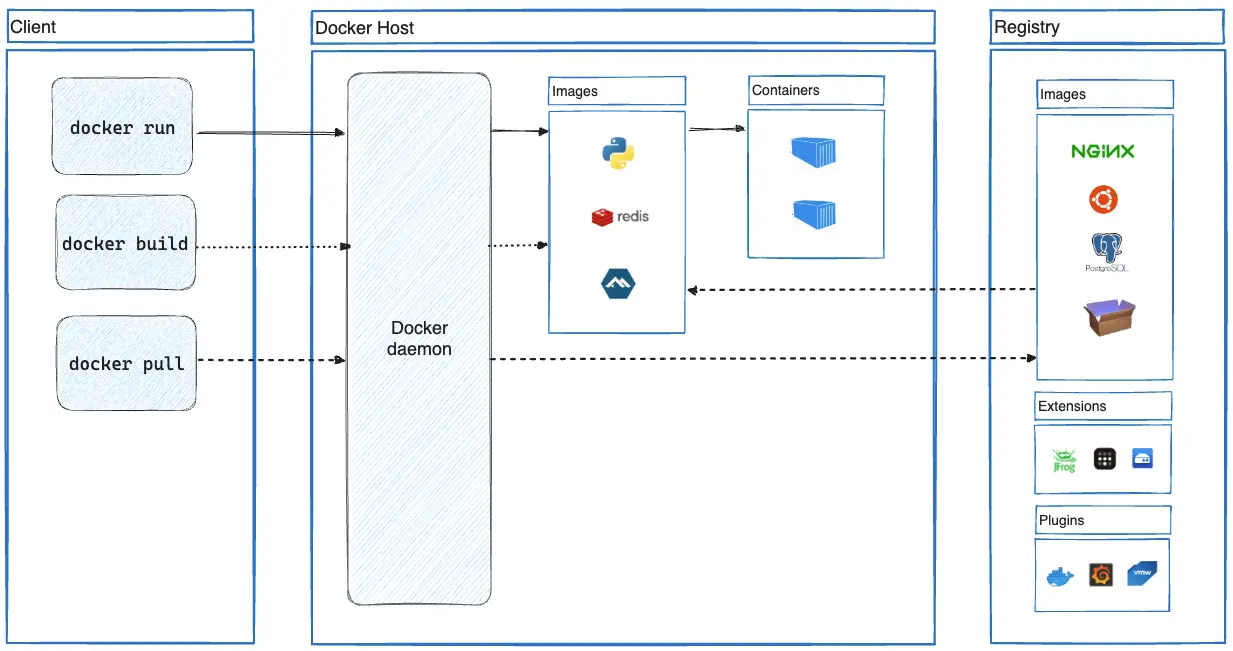

Comment Fonctionne Docker ?

Le diagramme officiel de haut niveau de l'architecture Docker ci-dessous illustre le flux de travail habituel de Docker :

Qu'est-ce que le Docker Daemon ?

Le daemon Docker reçoit les commandes du client Docker par l'intermédiaire de la CLI ou de l'API REST. Le client Docker peut se trouver sur le même hôte que le démon ou sur un autre hôte. Par défaut, le daemon Docker écoute le socket UNIX docker.sock. Si vous avez un cas d'utilisation pour accéder à l'API Docker à distance, vous devez l'exposer sur un port hôte.

Qu'est-ce qu'une Docker Image ?

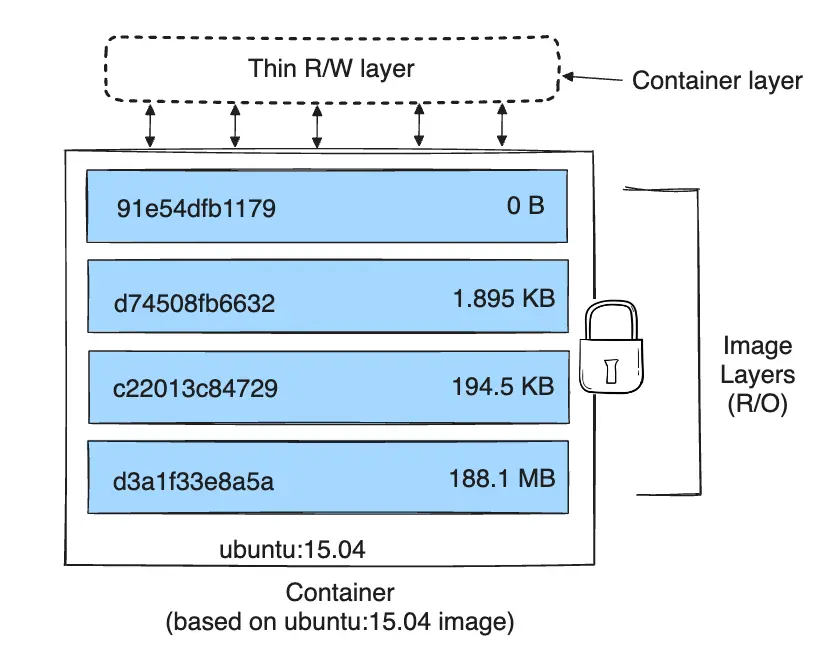

Une Docker Image est un fichier exécutable autonome qui contient tout ce dont une application a besoin pour fonctionner : le code, les bibliothèques, les dépendances, les variables d'environnement et les configurations. En d'autres termes, c'est une version statique et immuable de votre application et de son environnement d'exécution.

Une image Docker possède les caractéristiques suivantes :

- Immuabilité : Une fois construite, une image est figée et ne change pas. Toute modification ou mise à jour doit être effectuée via une nouvelle version de l'image.

- Portabilité : Les images Docker sont conçues pour être portables. Vous pouvez exécuter une image Docker sur n'importe quelle machine qui a Docker installé, quel que soit le système d'exploitation sous-jacent.

- Couches : Les images Docker sont construites en couches. Chaque instruction dans un Dockerfile (le fichier de définition de l'image) crée une nouvelle couche. Cela permet une gestion efficace des modifications et un partage de couches communes entre différentes images.

- Versioning : Les images peuvent être versionnées. Par exemple, vous pouvez avoir

myapp:1.0,myapp:1.1, etc. Vous pouvez aussi utiliser des tags pour marquer des versions spécifiques. - Création : Les images sont créées à partir d'un Dockerfile, un fichier texte contenant les instructions pour assembler l'image.

- Distribution : Les images Docker peuvent être partagées et distribuées via des registres Docker, comme Docker Hub ou des registres privés. Vous pouvez pousser des images vers un registre et les tirer pour les utiliser ailleurs.

Voici un exemple de Dockerfile :

# Choisir l'image de base

FROM ubuntu:20.04

# Installer des packages nécessaires

RUN apt-get update && apt-get install -y python3

# Copier le code source dans l'image

COPY . /app

# Définir le répertoire de travail

WORKDIR /app

# Spécifier la commande par défaut

CMD ["python3", "app.py"]Vous pouvez construire l'image Docker à partir du Dockerfile en utilisant la commande docker build :

docker build -t myapp:latest .Construction de l'image "myapp" avec la version "latest"

Une fois l'image construite, vous pouvez créer et exécuter un conteneur à partir de cette image avec :

docker run myapp:latestLancement de l'image docker

Qu'est-ce qu'un Docker Registry ?

Un Docker Registry est un système pour stocker et gérer des Docker Images. Il permet aux développeurs de partager des images Docker avec d'autres utilisateurs ou systèmes, facilitant ainsi la distribution et la gestion des versions des images.

Les fonctionnalités clés d'un Docker registry sont :

- Stockage des Images : Le registre stocke les images Docker, qui peuvent être publiées (pushed) et récupérées (pulled) par les utilisateurs.

- Gestion des Versions : Les registres permettent de gérer différentes versions d'une image en utilisant des tags. Par exemple, une image

myapppeut avoir des tags commev1.0,v1.1, etc. - Distribution et Partage : Les images stockées dans un registre peuvent être partagées avec d'autres utilisateurs ou déployées sur différents environnements.

- Sécurité : Les registres offrent des mécanismes de contrôle d'accès pour sécuriser l'accès aux images. Les utilisateurs peuvent nécessiter des authentifications pour accéder à certaines images ou registres.

- Recherches et Métadonnées : Les registres permettent de rechercher des images et de consulter des métadonnées associées, comme la taille de l'image, les couches, les dépendances, etc.

Un Docker registry peut être privée ou public (c'est à dire accessible à tous le monde). Voici quelques exemples de solutions de Docker registry :

- Docker Hub : C'est le registre public par défaut et le plus connu. Il héberge une grande quantité d'images publiques et peut également contenir des images privées. C'est le registre de référence pour la plupart des utilisateurs Docker.

- Amazon Elastic Container Registry (ECR), Google Container Registry (GCR), Azure Container Registry (ACR) : Ce sont des services de registre offerts par les principaux fournisseurs de cloud pour intégrer les images Docker avec leurs services cloud.

- Pour des registres privés pour stocker des images à usage interne ou restreint, des solutions open-source comme Harbor ou Quay sont couramment utilisées pour cette fin.

Voici comment pousser l'image précedente dans le registry de Docker Hub :

$ docker loginConnexion à Docker Hub

$ docker build -t monapp:latest .Construction de l'image "monapp" avec la version "latest"

docker tag monapp:latest monutilisateur/monapp:latestTag de l'image pour Docker Hub

docker push monutilisateur/monapp:latestEnvoi de l'image vers le Docker Hub

Qu'est-ce qu'un Docker Container ?

Vous pouvez empaqueter vos applications dans un conteneur, le tester et en faire une image de référence pour créer d'autres conteneurs à partir de cette image. Les conteneurs peuvent être démarrés, arrêtés, validés et supprimés.

Pour faire tourner un conteneur Docker en arrière-plan, vous pouvez utiliser l'option -d (ou --detach) avec la commande docker run. Voici un exemple de commande pour exécuter un conteneur NGINX en arrière-plan :

$ docker run -d --name nginx -p 8080:80 nginx

Unable to find image 'nginx:latest' locally

latest: Pulling from library/nginx

ea235d1ccf77: Pull complete

e29cef106877: Pull complete

e9bf20d5335e: Pull complete

1394e86b8f58: Pull complete

7b2b3e0f512f: Pull complete

6a11b5a77155: Pull complete

fb6d6e4aad9c: Pull complete

Digest: sha256:67682bda769fae1ccf5183192b8daf37b64cae99c6c3302650f6f8bf5f0f95df

Status: Downloaded newer image for nginx:latest

1f4b96d34deb27830fe2e08749734ecbb489de28b59be03f1807968e0c905144

Lancement d'un conteneur NGINX en arrière-plan

-d: Exécute le conteneur en mode détaché (en arrière-plan).--name nginx: Donne un nom personnalisé au conteneur pour faciliter son identification.-p 8080:80: Mappe le port 80 du conteneur au port 8080 de l'hôte, permettant d'accéder au service NGINX viahttp://localhost:8080.nginx: Spécifie l'image Docker à utiliser pour créer le conteneur (dans ce cas, l'image officielle NGINX).

$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

1f4b96d34deb nginx "/docker-entrypoint.…" About a minute ago Up About a minute 0.0.0.0:8080->80/tcp nginx

Liste les conteneurs en cours d'exécution

$ docker exec -it nginx shAccéder au conteneur nginx en mode interactif

$ docker logs nginxVisualisation des logs du conteneur nginx

$ docker stop nginxArrêt du conteneur nginx

$ docker rm nginx

nginx

Suppression du conteneur nginx

Idéalement, les conteneurs doivent être considérés comme des objets immuables, ce qui signifie qu'il est déconseillé d'apporter des modifications à un conteneur en cours d'exécution, sauf à des fins de test. Pour des changements permanents, il est préférable de créer une nouvelle image de conteneur.

Plusieurs conteneurs peuvent être reliés pour former une architecture d'application multi-niveaux. Pour gérer des applications hautement évolutives, l'utilisation d'outils d'orchestration de conteneurs, comme Kubernetes, simplifie considérablement le déploiement et la gestion des conteneurs à grande échelle.

Conclusion

En conclusion, Docker transforme le paysage DevOps en simplifiant la création, le déploiement et la gestion des applications grâce à ses conteneurs portables et isolés. En utilisant Docker, vous pouvez facilement partager des images via des registres, exploiter des outils d'orchestration comme Kubernetes, et tirer parti d'une vaste bibliothèque d'images disponibles sur Docker Hub

Que vous soyez novice ou expérimenté en DevOps, maîtriser Docker est essentiel pour améliorer l'efficacité de vos déploiements et garantir des environnements cohérents. Pour optimiser vos images et affiner vos compétences, explorez les meilleures pratiques et plongez-vous dans des projets pratiques. Docker est un allié puissant pour toute transformation DevOps réussie.